Windows Llama3 模型下载安装教程,5 分钟进行本地部署!

本文来介绍一下怎么在 Windows 中安装并下载 Llama3 模型。使用 Llama3 模型可以实现与 AI 对话的功能,通过 Ollama 工具,你可以在自己的电脑上运行这一模型。接下来,我们将分步骤说明如何完成安装和下载,以便你能够轻松地与 Llama3 开展对话。

本文来介绍一下怎么在 Windows 中安装并下载 Llama3 模型。使用 Llama3 模型可以实现与 AI 对话的功能,通过 Ollama 工具,你可以在自己的电脑上运行这一模型。接下来,我们将分步骤说明如何完成安装和下载,以便你能够轻松地与 Llama3 开展对话。

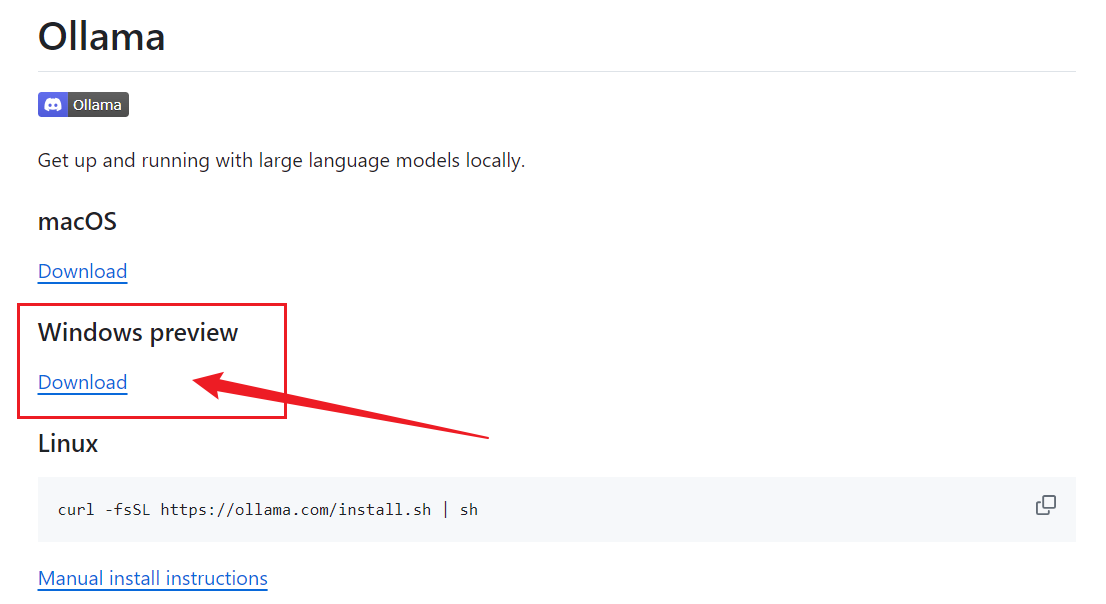

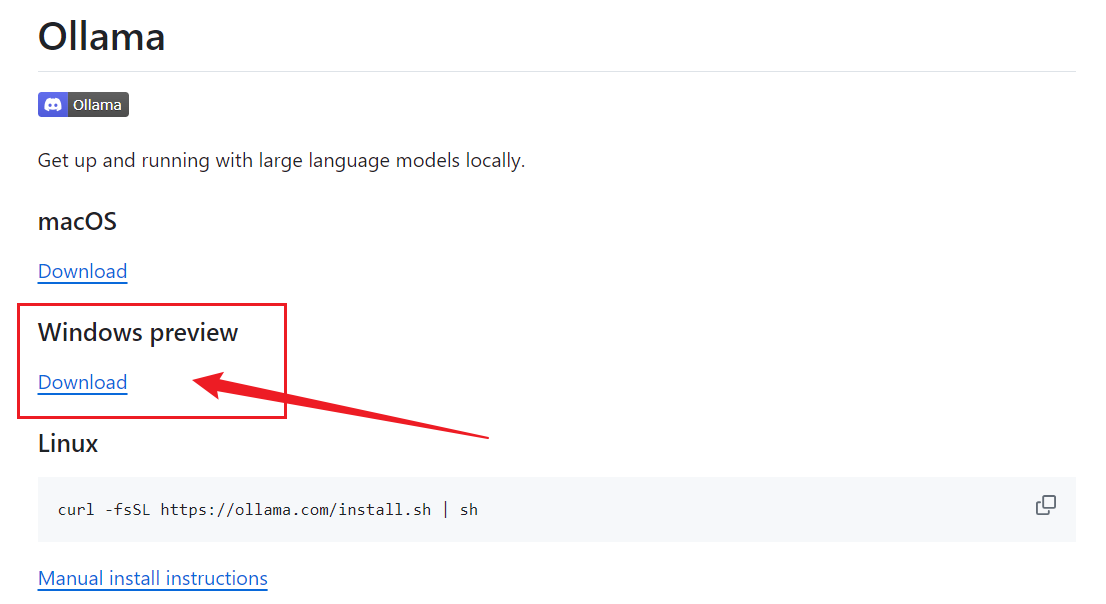

步骤 1:下载并安装 Ollama

首先访问 Ollama 的官方 Github 地址:https://github.com/ollama/ollama,然后在页面上选择 Winodws 进行下载:

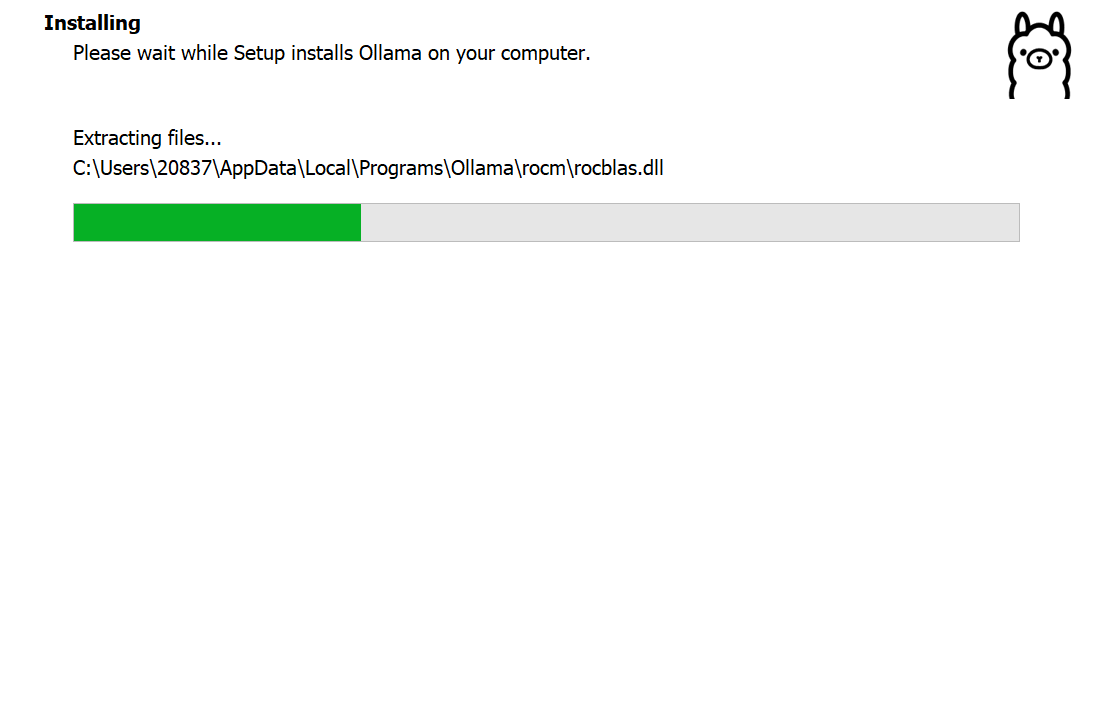

下载完成后安装即可,默认安装目录为 C 盘(默认不可选择安装路径,除非在系统环境中配置):

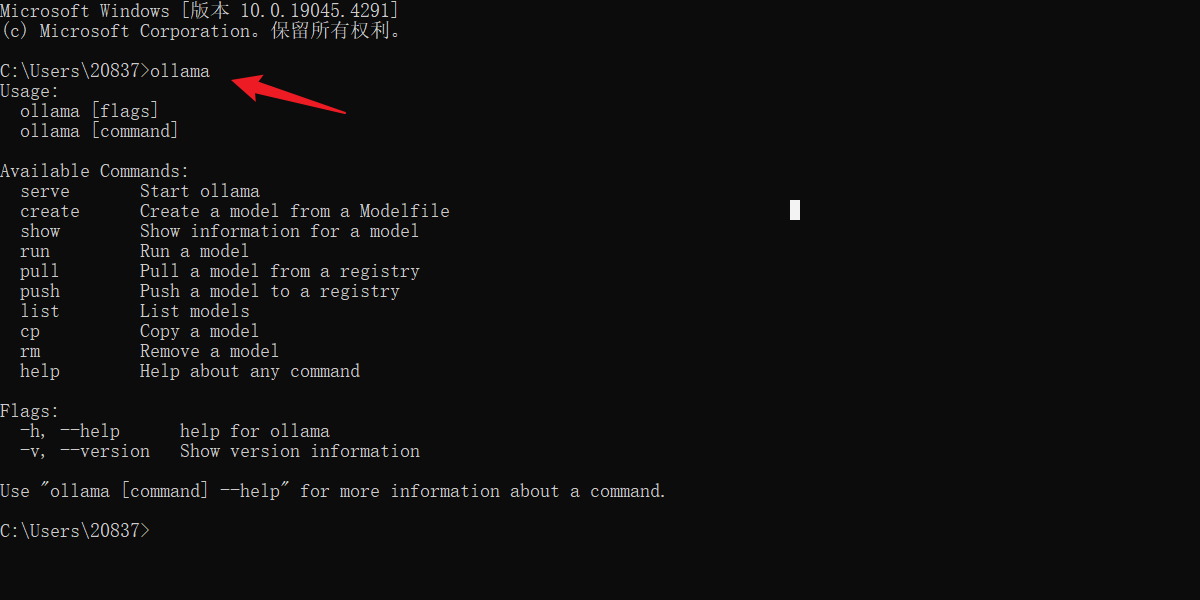

安装完成后,键盘选择Win + R打开控制台窗口,输入ollama后出现以下提示说明安装完成。

步骤 2:下载 Llama3 模型

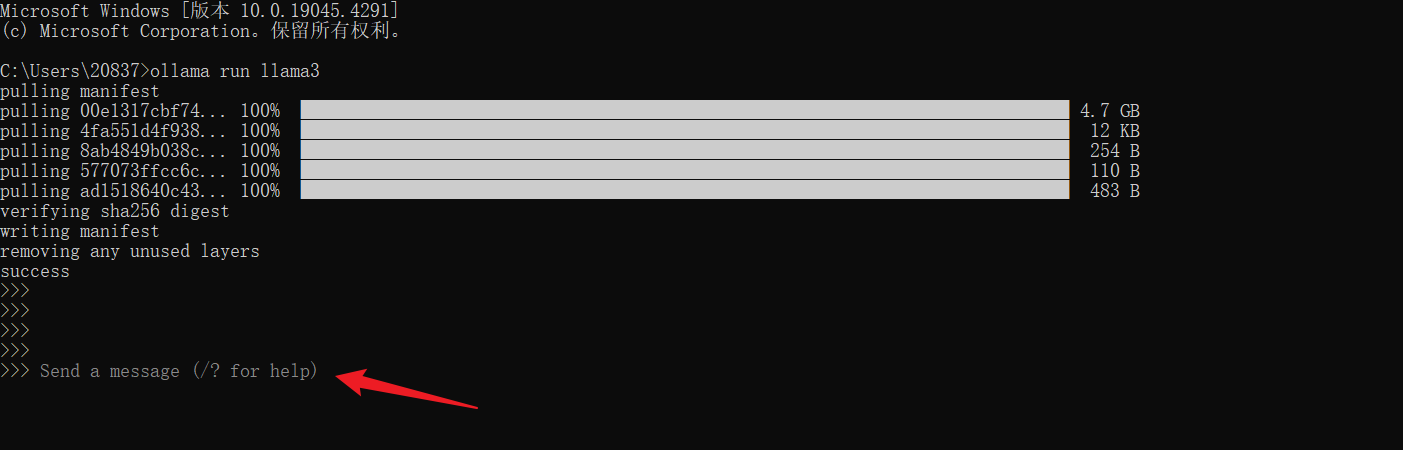

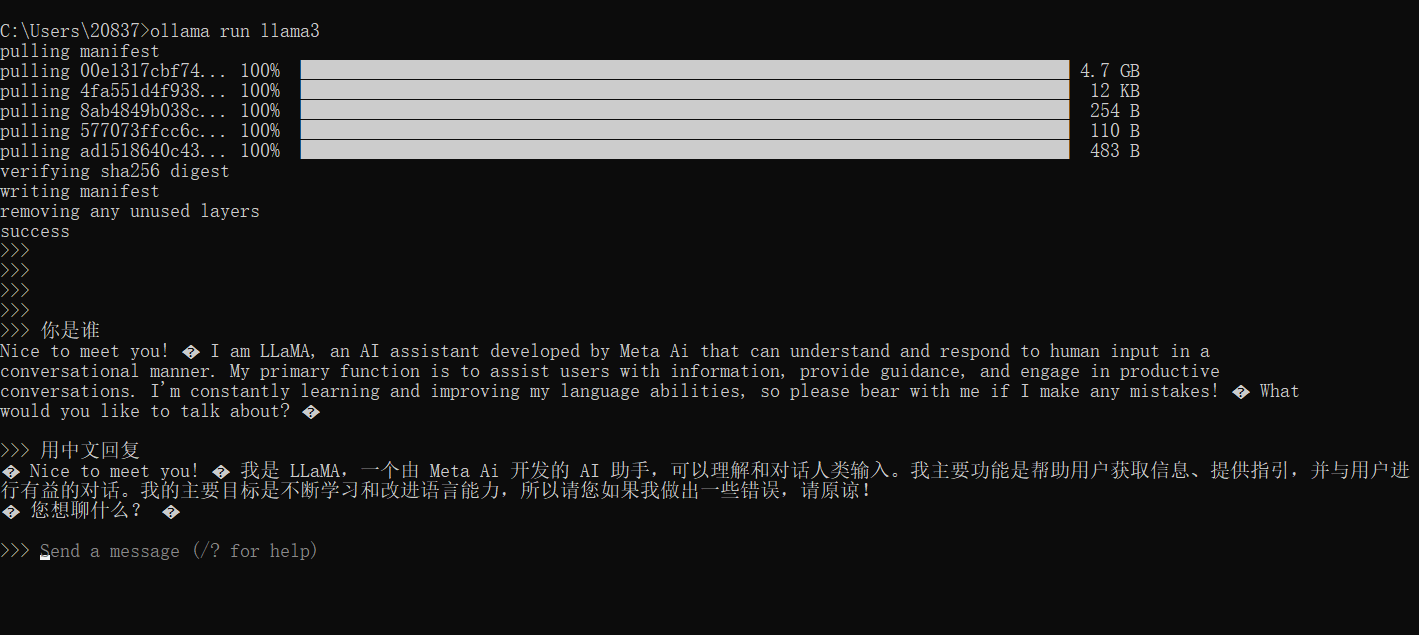

Ollama 安装完毕,我们还需要下载 Llama3 模型才可以使用,可输入以下命令来下载相关模型:

ollama run llama3当然,你可以根据你的系统配置来下载对应的模型,这是 Ollama 官方列出的模型,前面最新的两个就是 Llama3 模型:

Model | Parameters | Size | Download |

Llama 3 | 8B | 4.7GB | ollama run llama3 |

Llama 3 | 70B | 40GB | ollama run llama3:70b |

Phi-3 | 3,8B | 2.3GB | ollama run phi3 |

Mistral | 7B | 4.1GB | ollama run mistral |

Neural Chat | 7B | 4.1GB | ollama run neural-chat |

Starling | 7B | 4.1GB | ollama run starling-lm |

Code Llama | 7B | 3.8GB | ollama run codellama |

Llama 2 Uncensored | 7B | 3.8GB | ollama run llama2-uncensored |

LLaVA | 7B | 4.5GB | ollama run llava |

Gemma | 2B | 1.4GB | ollama run gemma:2b |

Gemma | 7B | 4.8GB | ollama run gemma:7b |

Solar | 10.7B | 6.1GB | ollama run solar |

在控制台中,出现这个界面代表正在下载(时间会有点久,此过程跟你的网速有关,最好科学上网):

当出现Send a message 提示时你就可以跟它进行对话了。

步骤 3:与 Llama3 开展对话

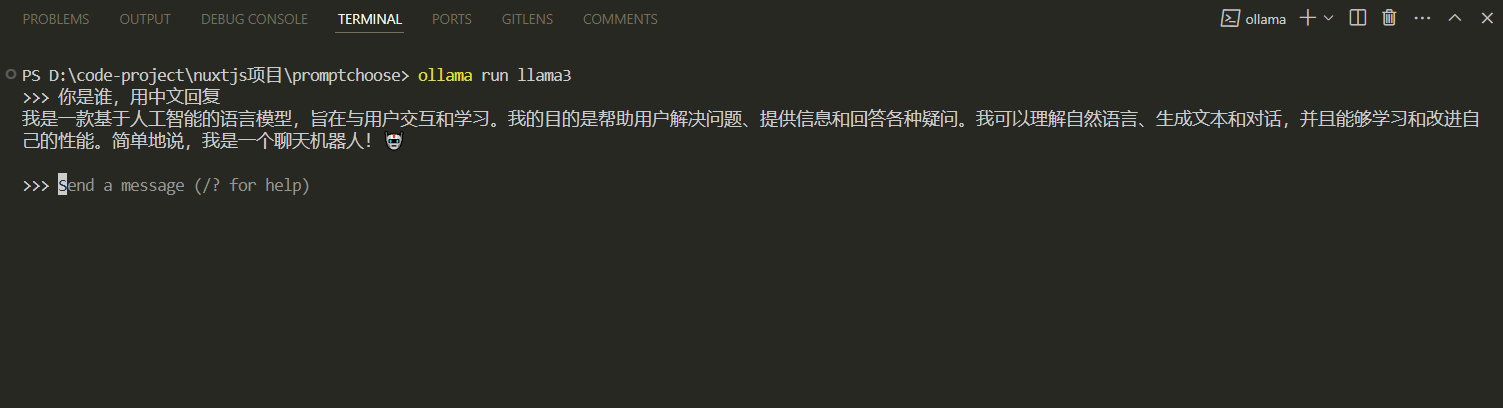

比如我给 Llama3 发送一个“你是谁,用中文回复”的对话:

你可以点击快捷键Ctrl+d来结束当前对话,当你关闭这个控制台窗口,下次还想开展对话的时候,也是运行这个命令ollama run llama3,你下载了哪个模型,就运行哪个。你也可以在任一控制台中运行这个命令,并开展对话,比如在 vscode 的控制台中:

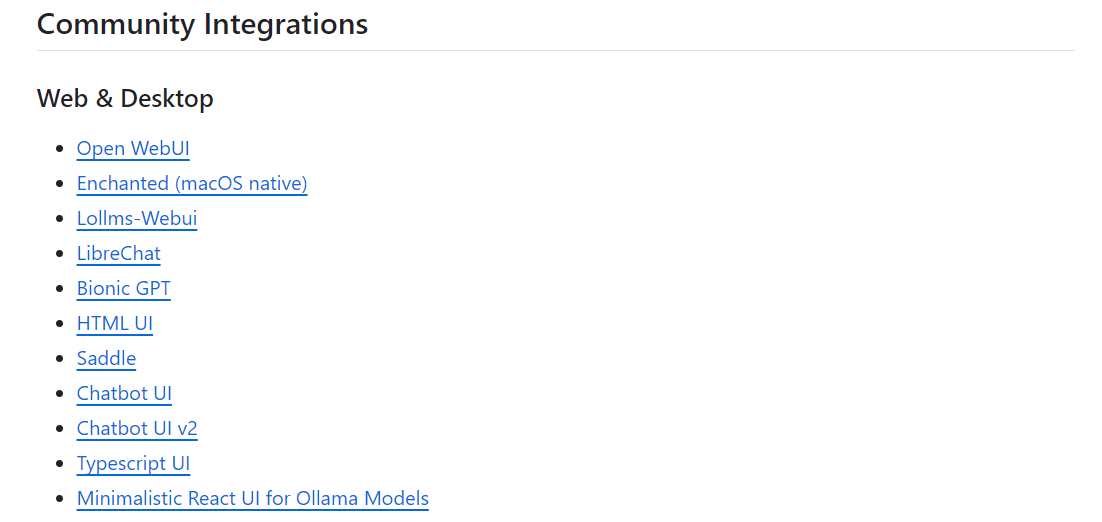

步骤 4:安装视图界面

每次都打开控制台来开展对话会非常的不方便,所以我们可以装一个 GUI 界面或者 Web 界面。Ollama 的官方 Github 上列有很多,你可以选择一个来安装,每个项目下都有详细的教程,有时间再详细展开说说。

总结

在 Windows 中使用 Ollama 进行对话的过程中,首先需要下载并安装 Ollama,然后下载所需的模型,例如 Llama3 模型。安装完成后,通过命令行与 Llama3 进行对话,可以在控制台或其他支持的环境中进行。为了更便捷地进行对话,可以选择安装 GUI 界面或 Web 界面。整个过程需要耐心等待下载完成,但一旦完成设置,即可随时与 Llama3 进行交流。

学习更多: